Les risques cachés de l’usage intensif de l’intelligence artificielle

Les risques cachés de l’usage intensif de l’intelligence artificielle dans les entreprises

L’intelligence artificielle (IA) s’impose de plus en plus comme un outil indispensable dans le monde des entreprises, offrant une efficacité accrue, une automatisation des tâches répétitives et une analyse de données avec une précision et une rapidité sans précédent. Cependant, il est crucial de considérer attentivement les dangers potentiels qu’elle peut engendrer. En effet, derrière ces promesses de productivité et de rentabilité, se cachent des risques potentiellement dévastateurs qui menacent de bouleverser l’équilibre fragile des entreprises. Des failles de sécurité aux biais algorithmiques, en passant par la dépendance technologique accrue, l’usage intensif de l’IA pourrait bien se révéler être une arme à double tranchant. Cet article explore les dangers souvent sous-estimés de cette révolution technologique dans le monde des entreprises.

Risques liés à la confidentialité et à la sécurité

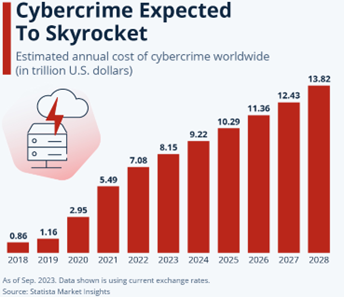

L’Intelligence Artificielle traite des ensembles massifs de données pour prendre des décisions éclairées, ce qui soulève des préoccupations majeures en matière de confidentialité et de sécurité des données. Les données sensibles des clients, des patients ou même des entreprises peuvent être compromises si des mesures de sécurité adéquates ne sont pas en place. Par exemple, dans le domaine médical, l’Intelligence Artificielle peut être utilisée pour analyser des dossiers médicaux et proposer des diagnostics. Cependant, si ces systèmes ne sont pas suffisamment sécurisés, les informations médicales confidentielles des patients peuvent être exposées à des cyberattaques, entraînant des violations de la vie privée et des pertes de données sensibles.

De plus, les entreprises utilisant l’Intelligence Artificielle pour gérer des informations financières doivent être particulièrement vigilantes. Les algorithmes d’IA peuvent être la cible de hackers cherchant à accéder à des données financières critiques, ce qui peut entraîner des conséquences désastreuses pour la sécurité financière et la confidentialité des données. La complexité et l’interconnectivité des systèmes d’IA rendent souvent difficile l’identification et la correction des vulnérabilités, augmentant ainsi le risque de violations de données. Une fois qu’une faille est exploitée, il peut être extrêmement difficile de remédier aux dégâts causés.

Dépendance Technologique et Perte de Compétences

L’automatisation à outrance peut entraîner une dépendance excessive à l’IA, où les compétences humaines sont mises de côté, créant ainsi une vulnérabilité potentielle. À mesure que les entreprises intègrent de plus en plus d’IA dans leurs opérations, cela peut conduire à une dégradation des compétences humaines essentielles, telles que la résolution de problèmes, la prise de décision et la créativité. Les employés peuvent devenir trop dépendants des recommandations des systèmes d’Intelligence Artificielle, négligeant leur propre jugement et leur expertise.

Cette perte de compétences peut rendre les entreprises vulnérables en cas de défaillance technologique. Les entreprises doivent maintenir un équilibre entre l’Intelligence Artificielle et l’expertise humaine, reconnaissant que l’IA est un outil pour aider, mais ne peut pas remplacer complètement l’intelligence humaine. Les situations complexes et les décisions stratégiques nécessitent souvent une nuance et un jugement que l’Intelligence Artificielle ne peut pas fournir. En outre, en cas de défaillance de l’Intelligence Artificielle, les entreprises qui ont trop compté sur ces systèmes peuvent se retrouver désarmées, incapables de fonctionner efficacement sans leur assistance.

Dans une interview avec WUNC, Satya Nadella, CEO de Microsoft, a discuté des promesses et des dangers potentiels de l’IA. Il a souligné l’importance de garder les humains au centre des systèmes d’IA pour éviter les erreurs et les malentendus : « Nous avons décidé de concevoir cela comme un copilote, pas un pilote automatique. L’humain doit rester en contrôle. » – WUNC

Biais et Discrimination

Les systèmes d’Intelligence Artificielle sont aussi performants que les données sur lesquelles ils sont formés. Cependant, ces données peuvent contenir des biais implicites, conduisant à des décisions discriminatoires. Mais qu’est-ce que cela signifie exactement ? Un biais dans le contexte de l’IA se réfère à une tendance systématique à favoriser certains résultats ou groupes de personnes par rapport à d’autres, souvent de manière injuste ou inéquitable. Ces biais peuvent être introduits à différents stades du développement de l’Intelligence Artificielle.

Par exemple, l’Intelligence Artificielle peut reproduire et amplifier les biais existants dans les données d’entraînement d’un algorithme, entraînant des résultats injustes ou discriminatoires. Un bot de service client formé sur des données biaisées où certaines questions de clients sont systématiquement négligées peut reproduire cette négligence, offrant une expérience client négative et inégale. Les biais dans l’Intelligence Artificielle peuvent également se manifester dans les systèmes de recrutement, où les algorithmes favorisent certains groupes démographiques au détriment d’autres, perpétuant ainsi les inégalités existantes.

Pour les entreprises, les biais dans les systèmes d’Intelligence Artificielle peuvent causer des dommages à leur réputation, des risques juridiques, des dommages économiques… entraînant des critiques publiques et des pertes de confiance des clients. Les entreprises doivent donc être vigilantes dans la conception et le déploiement de leurs systèmes d’IA, en mettant en place des mécanismes pour identifier et corriger les biais potentiels. Cela peut inclure des audits réguliers des systèmes d’Intelligence Artificielle, la diversification des données d’entraînement et l’implication de diverses parties prenantes dans le processus de développement. En prenant ces mesures, les entreprises peuvent minimiser les risques de biais et garantir que leurs systèmes d’IA fonctionnent de manière équitable et responsable.

"She declined to say how many employees were working on racial bias, or how much money the company had allocated toward the problem."

— @timnitGebru@dair-community.social on Mastodon (@timnitGebru) July 5, 2023

Simple question: what percentage of your humanity saving workforce is Black? For OpenAI, I bet it can be rounded to ZERO.https://t.co/IXyy7zWDvZ

Risque de désinformation et manipulation

Les systèmes d’IA peuvent être exploités pour diffuser de fausses informations à grande échelle et manipuler l’opinion publique, ce qui représente un danger considérable pour la société et la démocratie. Un exemple notoire est l’utilisation des modèles de langage avancés comme ChatGPT pour générer de faux contenus ou des Deepfakes pour créer des vidéos truquées qui peuvent faussement représenter des personnes réelles. Ces technologies peuvent être utilisées pour influencer les opinions politiques et semer la discorde.

La capacité de manipulation de l’IA soulève des défis éthiques et réglementaires importants. Les entreprises qui développent et déploient ces technologies doivent être conscientes des implications potentielles et prendre des mesures pour empêcher leur utilisation abusive. La réglementation et la responsabilité accrues dans l’utilisation de l’IA à des fins de communication et d’influence sont essentielles pour prévenir les abus et protéger la société. Sans contrôle approprié, l’IA peut devenir un outil puissant pour la désinformation.

Défaillance de l’IA et Responsabilité

Les systèmes d’IA jouent un rôle de plus en plus central dans divers secteurs, des soins de santé à la finance en passant par les transports. Cependant, leur complexité et leur dépendance aux données et algorithmes les rendent vulnérables aux erreurs. La défaillance d’un système d’Intelligence Artificielle peut avoir des conséquences désastreuses, parfois même catastrophiques. Par exemple, un algorithme de diagnostic médical défectueux peut recommander un traitement inapproprié, mettant ainsi la vie des patients en danger. De même, une défaillance dans un système de conduite autonome pourrait entraîner des accidents, causant des blessures ou des décès.

La question de la responsabilité en cas de défaillance de l’Intelligence Artificielle est particulièrement complexe. Qui est responsable en cas de défaillance de l’Intelligence Artificielle ? Le développeur du logiciel, l’entreprise qui l’a déployé, ou l’utilisateur final ? Ce flou juridique souligne la nécessité de développer des cadres réglementaires clairs et précis pour la responsabilité en cas de défaillance de l’IA. Les législateurs doivent travailler en collaboration avec les experts en technologie, les entreprises et les utilisateurs pour définir des règles et des normes qui clarifient la responsabilité et protègent toutes les parties impliquées.

Pour minimiser les risques de défaillance et clarifier la responsabilité, les entreprises doivent adopter une approche proactive :

- Tests Rigoureux : Mettre en place des processus de test approfondis pour identifier et corriger les bugs et les erreurs avant le déploiement.

- Surveillance Continue : Utiliser des outils de surveillance pour détecter les anomalies et les défaillances potentielles en temps réel.

- Formation des Utilisateurs : Former les utilisateurs finaux pour s’assurer qu’ils comprennent comment utiliser correctement le système et interpréter ses résultats.

- Clauses Contractuelles : Inclure des clauses claires dans les contrats concernant la responsabilité en cas de défaillance, définissant les obligations de chaque partie.

L’intégration de l’IA dans les entreprises offre des opportunités immenses pour améliorer l’efficacité et la productivité. Toutefois, il est impératif de ne pas ignorer les risques associés. Pour naviguer avec succès dans cette ère technologique, il est essentiel de mettre en place des mesures de protection robustes et une régulation stricte, de maintenir un équilibre entre l’Intelligence Artificielle et l’expertise humaine, et de promouvoir une utilisation éthique et responsable de ces technologies. Les entreprises peuvent ainsi tirer le meilleur parti de l’IA tout en minimisant les dangers potentiels. De plus, il est essentiel de s’intéresser aux innovations en matière de cybersécurité pour protéger les données sensibles et prévenir les cyberattaques, tout en continuant à explorer les potentiels de l’IA dans divers secteurs tels que la santé, l’éducation et la finance.